2024.05.03 (금)

n 기상청 제공

[기고] "창작-번역은 물론, 심지어 사기도 친다?" 못하는 게 없는 챗GPT 활용법

[연재] 챗GPT로 열린 새로운 생성 AI의 시대 #2

장중호 AI종합대학원 교수 칼럼

- 곽중희 기자

- 등록 2023.05.31 15:51

- 조회수 4,671

[글] 장중호 AI 종합대학원 교수, 공학박사

챗GPT의 인기가 연일 올라가는 가운데, 많은 사람들이 챗GPT를 활용하는 법들에 대해 블로그나 유튜브, 기사 등을 통해 이야기를 하고 있다. 지난 기고에서 나도 간단한 질문이나 소설 창작 등에 대한 예시를 들었지만, 과거에 생각할 수 있었던 활용 범위와 지금 생각할 수 있는 범주도 짧은 사이 엄청 늘어났다.

이것 저것을 챗GPT와 시도해보면서 사람들은 “아 이렇게도 이 것을 쓸수 있겠네?“ 라며 연일 놀라고 있다. Open AI의 사이트에서 직접 질문과 답변을 얻는 것도 흥미롭지만, 이미 MS의 엑셀이나 구글의 Sheet나 Docs와 챗GPT를 연결하여 여러 질문이나 미션을 한꺼번에 처리할 수 있는 기능이 점점 알려지면서 챗GPT는 마치 하나의 프로그램의 함수가 된 듯이 활용성이 엄청 커졌다.

챗GPT와 API 형태로 연동하여 좀 더 특화된 기능의 GPT들의 활용법이 소개되기 시작했는데 대표적인 몇 가지를 소개하면 다음과 같다.

<대표적인 챗GPT 활용법>

▲WebChatGPT : Google Search + 챗GPT = GPT를 가장 최근까지의 정보를 Google Search에서 찾아서 실행하는 기능

▲GPT for Sheets and Docs : Google Sheet/Docs + 챗GPT = GPT를 대용량으로 동시에 실행시키는 기능

▲ChatGPT for Gmail : Gmail 상에서 keyword 만 입력하면 챗GPT가 이메일을 써주는 기능

▲프롬포트 지니 : Google Translator + 챗GPT = 자동 번역 기능

▲ChatGPT to Notion : File 정리, 글씨기 등 챗GPT 결과를 폴더별로 정리해주는 기능

▲Youtube Summary with ChatGPT : Youtube 내용을 transcript로 바꾼 후 요약해주는 기능

▲Promptheus : Voice + ChatGPT = 목소리로 챗GPT를 실행할 수 있는 기능

▲Pictory : Video + ChatGPT =챗GPT로 작성한 script에 기반으로 자동으로 비디오를 생성해주는 기능’

▲GPTZero : AI로 쓴 글인지 검사하는 기능 (학생들이 제출한 과제 등이 ai가 썼는지, 인간이 썼는지 검사해주는 기능)

위 같이 다양한 솔루션이 있으면 좋겠다는 바람이 챗GPT와 융합한 기능들을 만들어내고 있다. 특히 Video를 자동으로 생성해주는 기능은 아직은 어설프지만 점점 사용하는 사람들이 많아지면서 학습이 되기 시작하면 점점 더 그 성능이 좋아질 것으로 보인다.

또 챗GPT로 쓴 학생들의 과제를 검사해주는 기능 또한 이제는 필수적으로 교수들이 사용하는 프로그램이 될 것이다. 그 외에도 지금 Youtube에 들어가면 챗GPT를 활용하여 돈 버는 법이라는 제목의 영상들이 엄청 많다. 대부분의 내용은 특정한 블로그 콘텐츠를 개발하는데 챗GPT를 활용하는 것인데, 내가 쓰고자 하는 블로그의 주제에 대한 글들을 자동 생성한다. 또한 생성된 글들의 Keyword 들을 뽑아낸뒤 다양한 이미지를 만들어주는 이미지 생성 AI를 써서 적당하게 저작권을 피할 수있는 그림이나 이미지를 생성해서 글과 붙이면 단 10분만에 근사한 블로그 콘텐츠를 생성한다. 그리고 그 것을 특정 마케팅 용도로 올려주고 광고회사나 브랜드 회사로부터 돈을 버는 것인데, 그럴싸한 이야기이다.

B2C사업을 하는 모든 브랜드나 유통사 등의 마케팅은 디지털 세상에서 자사에 대한 좋은 홍보 콘텐츠를 많이 만들어 뿌려서 다양한 연령대나 취향의 사람들에게 구글이나 네이버의 검색 결과에 걸리도록 하고 있다. 다양한 SNS 채널에서 노출이 되는 것이 마케팅의 핵심인데, 여기에서 콘텐츠를 제작하는데 들어가는 시간과 비용을 대폭 줄일 수 있는 것이다.

그 외에도 번역이나, 논문 요약이나 논문 대필, 영상 생성 등 다양한 분야를 이전에는 그 분야의 전문가들이 지식을 기반으로 할 수있었던 일들을 챗GPT에 기대어 일반인들도 할 수 있게 만든다.

챗GPT는 GPT라는 알고리즘에 기반한다. 최근 알려진 GPT는 버전 3.5인데 한층 업그레이드 된 4.0 버전이 나와서 챗GPT가 더욱 정교하게 업그레이드 됐다고 알려져 있다. GPT 알고리즘을 일반인들이 설명을 듣는다고 쉽게 이해하기는 어렵지만, 그래도 가장 기본적인 GPT에 대한 지식은 있어야 앞으로의 지속적으로 발전할 초대형 AI라는 분야에 대해 이해할 수 있기에 여기서 간단한 알고리즘과 관련된 용어와 개념만이라도 이해하면 좋겠다.

GPT는 "Generative Pre-trained Transformer"의 약어로, 딥러닝 알고리즘 중 하나이다. GPT 모델은 OpenAI라는 회사에서 개발하였으며, 자연어 처리(NLP) 분야에서 활용되며, 대표적으로 텍스트 생성, 기계 번역, 질의응답(QA), 요약 등에 사용된다.

챗GPT를 만든 OpenAI는 2015년에 설립됐으며, 인공지능의 잠재력을 최대한 발휘해 인류의 복지를 증진을 목표로 한 비영리 기업이다. 테슬라의 유명한 엘론 머스크와 샘 알트만, 그렉 브록만 등의 대표적인 기업인, 인공지능 전문가 및 학자들이 모여 만들었다. 하지만 지속적으로 비영리 개념으로 학습에 엄청난 컴퓨팅 자원과 비용이 들어가는 초대형 AI에 대한 연구를 계속할 수 없어 2019년부터 MS와 손을 잡고 투자를 받았다. 이후 2023년까지 누적으로 100억 달러, 한국 돈으로 약 13조에 달하는 지원을 받아 지금은 거의 영리 기업이 됐다.

GPT 모델은 "Transformer"라는 구조를 기반으로 한다. Transformer는 NLP 분야에서 최신의 AI 모델 구조 중 하나로, 기존의 RNN(Recurrent Neural Network) 구조보다 훨씬 긴 시퀀스를 처리하는데 용이하다. GPT 모델은 이 Transforme 구조를 이용하여 사전 학습(pre-training)을 거쳐 강력한 자연어 이해 능력을 갖췄다. GPT 모델은 대규모 말뭉치(corpus)에서 사전 학습을 거친 후, 이를 fine-tuning하여 특정한 NLP 작업에 활용한다.

예를 들어, 언어 모델링(Language Modeling) 작업을 위해서는 GPT 모델에 일부 문장을 입력하면, 이어지는 단어를 예측하도록 학습시킨다. 이렇게 학습된 GPT 모델은 다양한 자연어 처리 작업에 활용될 수 있으며, 가장 적합한 것은 인간과 대화하는 Chat-bot의 기능에 최적화되어 지금의 챗GPT로 발전한 것이다.

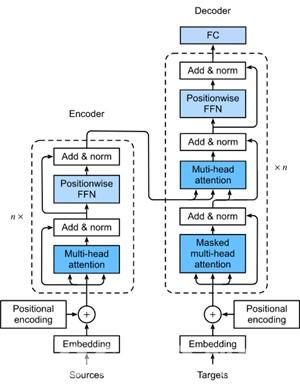

Transformer 모델은 다음과 같은 구성 요소로 이뤄져 있다.

1. Encoder: 입력 문장을 순차적으로 입력받아 단어 임베딩(Word Embedding) 벡터로 변환한 후, Self-Attention을 통해 각 단어의 상호 관계를 파악한다. 그리고 다층 퍼셉트론(MLP)을 이용해 각 단어 벡터를 변환하여 다음 계층으로 전달한다.

2. Decoder: 출력 문장을 순차적으로 입력받아 단어 임베딩 벡터로 변환한 후, Encoder와 비슷한 방식으로 Self-Attention을 통해 각 단어의 관계를 파악한다. 또한, 다른 입력으로부터 정보를 받아오기 위해 Encoder-Decoder Attention을 수행한다. 마지막으로, 다층 퍼셉트론(MLP)을 이용해 각 단어 벡터를 변환하여 다음 계층으로 전달한다.

3. Multi-Head Attention: Self-Attention과 Encoder-Decoder Attention에서 사용되는 구조로, 입력 벡터를 여러 개의 부분 집합으로 나눈 후, 각 부분집합에서 Attention을 계산한다. 이렇게 계산된 결과를 합쳐서 최종 Attention을 얻는다.

GPT 모델의 장점은 RNN과 달리 입력 문장을 병렬적으로 처리할 수 있기 때문에 연산 속도가 빠르다는 것이다. 또한, Self-Attention을 통해 입력 문장의 모든 단어를 한 번에 처리하기 때문에, 문맥 파악 능력이 뛰어나다는 장점도 있다.

이러한 장점으로 Transformer 모델은 자연어 처리 분야에서 혁신적인 성능을 발휘하고 있다. Transformer를 이해하려면 위에 언급된 RNN이라는 대표적인 딥러닝 알고리즘에 대해서 알아야 하는데, RNN(Recurrent Neural Network)은 시계열 데이터와 같은 순차적인 데이터를 처리하는 데에 사용된다. RNN은 입력과 출력을 시퀀스(sequence)로 처리한다. 또한 이전 상태의 출력을 현재의 입력으로 사용하여 순차적인 데이터를 처리하는 특징을 가지고 있다. 하지만 긴 시퀀스 데이터에 대해서는 정보가 손실될 가능성이 있고 학습에 필요한 계산량도 많아지게 된다.

이러한 RNN의 한계를 극복하고자 구글의 연구팀인 Google Brain은 2017년 Transformer라는 알고리즘을 개발했다. Transformer는 입력 시퀀스의 전체 정보를 동시에 처리할 수 있는 구조를 가지고 있어 입력 시퀀스의 모든 단어 벡터를 동시에 처리한다. self-attention 메커니즘을 사용해 입력 단어 간의 상호작용을 파악한다. 이러한 구조 덕분에 Transformer는 긴 시퀀스 데이터에 대해서도 효과적인 처리가 가능하며 RNN보다 빠른 학습 속도와 높은 성능을 발휘할 수 있는 것이다.

GPT는 최신 알고리즘에다 MS의 전폭적인 컴퓨팅 파워에 대한 지원을 받고 있다. 천문학적인 1,750억개의 파라미터, 즉 학습을 위한 셀을 통해 전세계 인터넷에 떠돌아다니는 왠만한 데이터들로 학습을 시킨 모델이 바로 챗GPT다. 말이 1,750억개의 파라미터이지 그 의미를 인간과 비교해보면 인간의 뇌에는 대략 1,000억개의 신경세포(뉴런)이 있고, 하나의 신경세포에서 수천개의 다른 세포와 연결되는 가지가 나와 있어 대략 수십조개의 연결돌기(시냅스)가 존재한다. 명확히 비교할 순 없지만 1,750억개의 파라미터는 수십조개의 인간의 뇌 안에 존재하는 연결돌기의 1/100 정도다. 인간의 뇌에 근접한 복잡한 구조를 가지고 학습을 시켜 인간의 기억과 언어 능력만큼의 역량을 가진다.

사실 인간의 신경세포는 단순 기억이나 언어 영역에 해당되는 것만 있는 것이 아니라 운동신경이나 다양한 감각기관, 자율신경 등 복잡한 것들이 복합화돼 있는데, 기억과 언어영역만 1,750억개라 하면 거의 인간의 뇌구조와 비견될 만큼의 방대한 신경망의 규모라고 이해하면 된다.

지금까지 간단하게 GPT 모델의 알고리즘에 대해서 알아봤다. 더 깊은 기술적인 내용은 챗GPT의 다양한 활용모델을 알아가면서 차차 설명해보도록 하겠다. 우리가 챗GPT를 활용할 때 반드시 명심해야 할 것은 챗GPT는 마치 실제 인간의 언어행동 방식과 비슷해서 사실 오류도 많고, 자신이 잘 모르고 이해하지 못하는 부분도 능청맞게 아는 척, 문장을 만들어 내어 그럴듯하게 보이는 부분이 많다는 점이다.

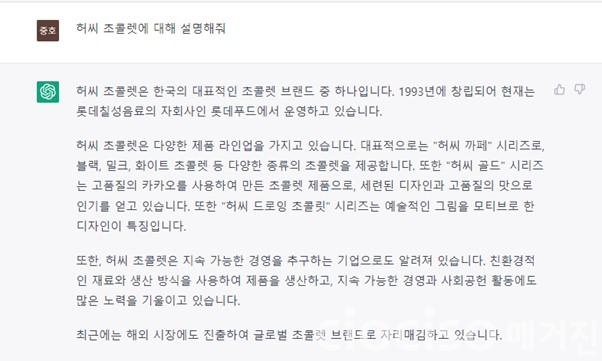

요즘 인터넷을 보면 챗GPT의 능청스러운 거짓말들을 찾아내고 올리는 재미있는 글들이 많은데, 그중의 하나가 ‘허씨초코렛’ 이다. 허쉬초코렛을 잘못써서 허씨초코렛이라고 써서 물어봤을 때, 사실 존재하지 않는 브랜드인데도 마치 있는 것처럼 말을 지어낸 내용들인데, 그 자연스러움이 재미있다. 아래와 내용과 같다.

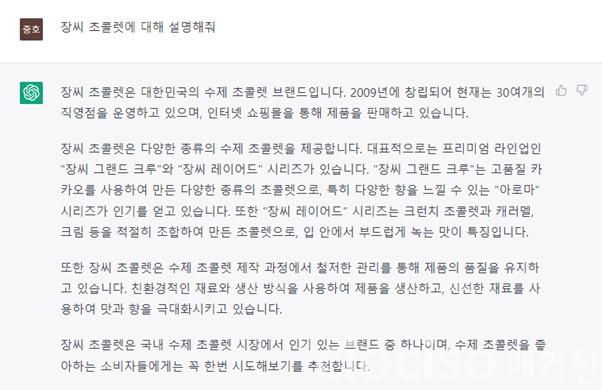

징씨 초콜릿에 대해서도 물어봤다. 마찬가지로 엉뚱한 답을 내놓았다. 위의 예를 보듯이 챗GPT는 오류도 많고 한계가 있다. 오히려 이런면이 더 인간답고 친근할지도 모르겠다. 하지만 우리가 활용할 때는 이러한 한계를 반드시 인지하고 사용을 해야 낭패를 피할 수도 있다는 것을 기억해야 한다.

<장중호 칼럼니스트>

[약력]

현, 서울과학종합대학원 AI공학대학원 교수

전, 홈플러스 마케팅부문장/전무

전, GS홈쇼핑 마케팅부문장/상무

전, 이마트 마케팅담당/상무

전, 딜로이트 컨설팅 전략컨설팅 상무

전, PwC 컨설팅, 전략컨설팅 상무

[학력]

미, Texas A&M University, 컴퓨터공학 석사/박사 (1996년)

연세대 전자공학과 졸 (91년)

경기고등학교 졸 (87년)

Copyright @2024 CIOCISO매거진. All rights reserved.

![[칼럼] IT관리에 반드시 필요한 AD(Active Directory)의 명(明) 과 암(暗) – 7편 [칼럼] IT관리에 반드시 필요한 AD(Active Directory)의 명(明) 과 암(暗) – 7편](http://ciociso.com/data/file/news/thumb-237248888_d0LZm7VM_2f9484b76e80219e381d870a861ae95684fb4384_118x78.jpg)